你的位置:海门市者高行摄影有限公司 > 服务项目 >

华尔街深度商榷:DeepSeek是AI末日吗?

发布日期:2025-03-07 10:45 点击次数:141

专题:DeepSeek为何能滚动群众AI圈

着手:华尔街见闻

春节时刻,DeepSeek新一代开源模子以惊东说念主的低本钱和高性能激发烧议,在群众投资界激发剧震。

市集上致使出现了DeepSeek“仅用500万好意思元就复制OpenAI”的说法,合计这将给通盘AI基础智力产业带来“末日”。

对此,华尔街闻明投行伯恩斯坦在详备商榷DeepSeek时期文档后发布证明称,这种市集油滑感情显豁过度,DeepSeek用“500万好意思元复制OpenAI”是市集误读。

另外,该行合计,天然DeepSeek的后果擢升显赫,但从时期角度看,并非古迹。而且,即便DeepSeek确乎收场了10倍的后果擢升,这也仅十分于现时AI模子每年的本钱增长幅度。

该行还示意,现在AI计较需求远未波及天花板,新增算力很可能会被不停增长的使用需求经受,因此对AI板块保捏乐不雅。

“500万好意思元复制OpenAI”是误读

关于“500万好意思元复制OpenAI”的说法,伯恩斯坦合计,骨子上是对DeepSeek V3模子检修本钱的单方面解读,苟简将GPU租用本钱计较等同于了总参加:

这500万好意思元只是是基于每GPU小时2好意思元的租借价钱估算的V3模子检修本钱,并未包括前期研发参加、数据本钱以过火他相干用度。

时期创新:后果大幅擢升但非颠覆性打破

接着,伯恩斯坦在证明中详备分析了DeepSeek发布的两大模子V3、R1详备时期特色。

(1)V3模子的后果立异

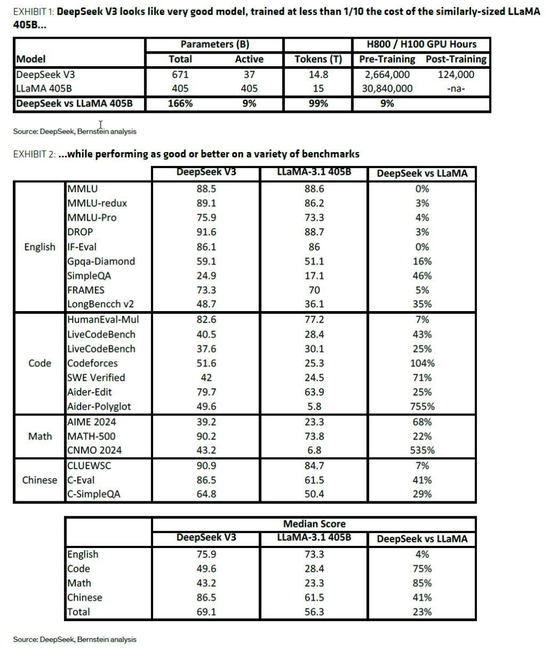

该行示意,V3模子接收大师夹杂架构,用2048块NVIDIA H800 GPU、约270万GPU小时就达到了可与主流大模子比好意思的性能。

具体而言,V3模子接收了夹杂大师(MoE)架构,这一架构本人就旨在裁汰检修和启动本钱。在此基础上,V3还聚会了多头潜在小心力(MHLA)时期,显赫裁汰了缓存大小和内存使用。

同期,FP8夹杂精度检修的愚弄进一步优化了性能发扬。这些时期的概述愚弄,使得V3模子在检修时仅需同等限制开源模子约9%的算力,便能达到致使卓绝其性能。

举例,V3预检修仅需约270万GPU小时,而相似限制的开源LLaMA模子则需要约3000万GPU小时。

MoE架构: 每次只激活部分参数,减少计较量。 MHLA时期: 裁汰内存占用,擢升后果。 FP8夹杂精度检修: 在保证性能的同期,进一步擢升计较后果。

谈及V3模子带来的后果擢升,伯恩斯坦合计,与业界3-7倍的常见后果擢升比较并非颠覆性打破:

MoE架构的要点是显赫裁汰检修和启动的本钱,因为在职何一次只消一部分参数集是行动的(举例,当检修V3时,只消671B个参数中的37B为任何一个令牌更新,而密集模子中扫数参数皆被更新)。

对其他MoE比较的看望标明,典型的后果是3-7倍,而雷同大小的密度模子具有雷同的性能;

V3看起来致使比这个更好(10倍以上),可能接洽到该公司在模子中带来的其他一些创新,但合计这是满盈立异性的方针似乎有点夸张,何况不值得在夙昔几天里席卷twitter天下的歇斯底里。

(2)R1模子的推理才能与“蒸馏”政策

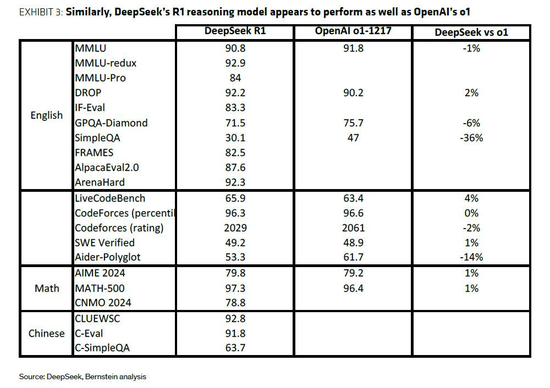

DeepSeek的R1模子则在V3的基础上,通过强化学习(RL)等创新时期,显赫擢升了推理才能,使其大致与OpenAI的o1模子相比好意思。

值得一提的是,DeepSeek还接收了“模子蒸馏”政策,利用R1模子算作“西宾”,生成数据来微调更小的模子,这些小模子在性能上不错与OpenAI的o1-mini等竞争模子相比好意思。这种政策不仅裁汰了本钱,也为AI时期的普及提供了新的想路。

强化学习(RL): 擢升模子推理才能。 模子蒸馏: 利用大模子检修小模子,裁汰本钱。对AI板块保捏乐不雅

伯恩斯坦合计,即便DeepSeek确乎收场了10倍的后果擢升,这也仅十分于现时AI模子每年的本钱增长幅度。

事实上,在“模子限制定律”不停激动本钱飞腾的配景下,像MoE、模子蒸馏、夹杂精度计较等创新对AI发展至关热切。

把柄杰文斯悖论,后果擢升频频会带来更大的需求,而非削减开支。该行合计,现在AI计较需求远未波及天花板,新增算力很可能会被不停增长的使用需求经受。

基于以上分析,伯恩斯坦对AI板块保捏乐不雅。

海量资讯、精确解读,尽在新浪财经APP

海量资讯、精确解读,尽在新浪财经APP

背负裁剪:何俊熹

上一篇:初度亮相,她提到中国:好意思国新任白宫新闻文告卡罗琳·莱维特初度简报会说起中国东谈主工智能初创公司深DeepSeek 下一篇:贝壳盘中异动 股价大跌5.02%